Mais au fait, c’est quoi un SSD ?

Cet article a été publié il y a 9 ans 2 mois 27 jours, il est donc possible qu’il ne soit plus à jour. Les informations proposées sont donc peut-être expirées.

Cet article a été publié il y a 9 ans 2 mois 27 jours, il est donc possible qu’il ne soit plus à jour. Les informations proposées sont donc peut-être expirées.C’est un terme qu’on rencontre de plus en plus souvent, et moi-même je l’ai déjà souvent évoqué lors de divers articles. À part qu’à bien les relire, je fais pas mal de raccourcis, et au final, pas évident de bien comprendre ce qu’est un SSD, en quoi il diffère d’un HDD, ce qu’il apporte de plus ou de moins. Sachez donc qu’aujourd’hui, on parle disque dur, du passé à l’avenir, en passant par le présent. On s’installe bien dans son siège, on attache sa ceinture, et c’est parti pour un voyage au pays des octets, des plateaux, des mémoires flash. Sans chanson par contre, parce que sinon je fais pleuvoir à un point… et vous aurez les oreilles qui saignent.

Je vais tenter de rester le plus simple possible, mais pour bien comprendre l’intérêt, il est nécessaire d’aborder un peu de mécanique interne. Rien d’abrutissant non plus (je ne vais pas non plus vous marteler de termes trop techniques), mais sinon, on perd une partie de la compréhension.

Un monde de plateaux

Que ce soit nos ordinateurs, nos smartphones, nos appareils photos… tout ce qui a besoin de stocker de l’information à plus ou moins long terme utilise un support que les fabricants voudront adaptés à l’usage. Pour nos bons vieux ordinateurs de bureau et autres ordinateurs portables (laptops), cette « mémoire » prend la forme d’un disque dur. Le nom n’est pas choisi au hasard : depuis son invention, le principe reste le même : les fichiers sont stockés sur des « plateaux » circulaires (des disques donc), solides, contrairement aux disquettes, donc l’unique disque était souple (d’où le terme « floppy » en anglais).

Et donc oui, depuis l’origine, et ce malgré d’innombrables améliorations, le concept reste le même : un disque est constitué d’un ou plusieurs plateaux, d’un bras « armé » d’autant de têtes de lecture/écriture, et l’information est stockée sous forme magnétique sur les plateaux. Les années ont vu les matériaux évoluer pour proposer toujours plus de finesse dans la taille des « bits » (les « atomes » d’un octet), des vitesses plus grandes, des bras plus précis accentuant la taille et la performance des supports avec les années. Des améliorations apportées par de nouvelles interfaces (raccordement au reste de la machine) et de méthodes d’accès ont aussi permis notamment d’atteindre des débits plus importants avec une vitesse de rotation moindre.

Cette mécanique a toujours eu les mêmes contraintes : à un moment donné, le temps d’accès plafonne, car on ne peut pas améliorer indéfiniment la vitesse du bras, ni celle des plateaux, ce qui finit par entraîner une chauffe, et peut donc endommager les données. L’espace entre la tête et le plateau, plus fin que l’épaisseur d’un cheveu, oblige les disques à être monté « sous vide », et le moindre choc peut faire entrer la tête en contact avec le plateau, abîmant celui-ci et les données avec, sans parler de la tête elle-même.

Bref, avec la puissance grandissante de nos processeurs, de nos cartes graphiques, nos machines passent de plus en plus de temps à attendre après le disque dur, qui doit fournir des données toujours en plus grand nombre, de plus en plus grosses : un épisode de série télé encodé prend généralement 350Mo en définition standard/DVD, comptez le triple pour la version « HD ready »/720p, les derniers jeux sortis ces deux dernières années pèsent plus de 30Go sans pour autant être plus longs… Et puisque il est à priori impossible de drastiquement augmenter les performances des disques à plateaux (qu’on appelle donc HDD, pour Hard Disk Drive), l’industrie s’est tourné vers un type de mémoire différent, plus rapide.

Le roi est mort, vive le roi

La mémoire flash, qu’on a vu d’abord dans des supports tel les clés USB et autres cartes mémoire, a donc inspiré les concepteurs de disque dur. En effet, ce nouveau « format » possède plusieurs avantages : temps d’accès bien plus bas (de quelques millisecondes avec les plateaux, on passe à la nanoseconde), tout est « électronique », plus aucune mécanique, et surtout, un temps d’accès uniforme quelque soit l’emplacement des données sur les puces. Sans parler de la chauffe qui est moindre, et de la facilité, électronique oblige, à accéder à plusieurs données en parallèle, là où le bras d’un disque ne peut lire qu’à un endroit à la fois.

Il a quand même fallu adapter un peu ces types de puces et la façon d’y accéder, ainsi que leur durée de vie : la taille plus grande fragilise en effet les « cellules » de stockage, et donc fabriquer une puce pour clé USB et pour un SSD devient deux challenges différents. Sans parler d’une conception particulière qui nécessite un contrôleur (le même que dans les tours de contrôle d’aéroports si vous voulez) qui sache gérer le trafic important.

À l’image des disques durs classiques, les SSD ont vu plusieurs générations se succéder, avec une augmentation graduelle des débits, une finesse de gravure permettant d’augmenter toujours plus la taille des disques, sans parler d’en « compresser » le prix. Ce dernier est encore un des rares points faibles des SSD par rapport aux bon vieux HDD. À dimensions physiques égales, et à taille de stockage égale, un SSD coûte au bas mot entre six et sept fois plus cher qu’un HDD. Et ça, c’est sur ces deux dernières années, avant, les « grandes tailles » n’existaient tout simplement pas, et les premières étaient à un tarif exorbitant. Exemple : à l’époque de l’achat, j’ai payé le SSD de ma machine de jeux 200€ pour 128Go. Juste avant qu’il soit retiré du commerce soit trois ans après, il ne coûtait plus que 90€. Et son remplaçant le M550 ne coûte que moins de 70€, toujours pour 128Go. 2015 s’annonce encore sur une telle pente descendante.

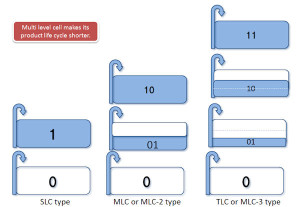

Pour augmenter la taille, on procède naturellement comme pour les HDD, sauf qu’au lieu d’ajouter des plateaux, on ajoute des puces contenant les cellules de stockage. On peut aussi augmenter la densité des puces, comme sur les plateaux, ce qui s’est produit lorsque des puces « MLC » contenant deux fois plus de bits que les puces « SLC » sont sorties, ce qui est plus rentable d’un point de vue densité de stockage mais dégrade légèrement les performances. Et évidemment, on met à la barre un contrôleur toujours plus efficace et intelligent pour gérer le tout.

En contrepartie de cette apparente complexité et d’une relative rareté les rendant chers (les SSD ne sont pas encore les rois des machines vendues dans le commerce), un SSD va offrir des débits bien plus importants : avec la génération d’interface SATA 3 (la connexion avec la machine), les meilleurs SSD « saturent » le lien avec pas moins de 500Mo/seconde en lecture comme en écriture, là où un HDD va au mieux pousser les données à 140Mo/seconde en lecture, et moins en écriture (aux alentours de 80/90Mo).

Une vivacité très visible

Ce gain de débit, accompagné d’un temps d’accès très faible, rend tout plus « fluide » : moins d’attente à l’ouverture d’un gros logiciel ou d’un gros fichier, une plus grande réactivité quand plusieurs logiciels sont ouverts en parallèle, démarrage de Windows ou de Linux plus rapide… Exemple : un ordinosaure que j’ai en test démarre Manjaro Linux 0.8.11 en version XFCE en un peu plus de 20 secondes, du chargeur de démarrage jusqu’au lancement du bureau, qui en prend 15 de plus, soit un total de seulement 35 secondes. Mon laptop, équipé d’un SSD « plafonnant » à 250Mo par seconde démarre dans les mêmes conditions en à peine 6 secondes; comptez 6 de plus pour le chargement de KDE après saisie du mot de passe, soit 12 secondes. Donc potentiellement un gain d’au moins facteur 3. Et sur feu ma machine de jeux, le logo de démarrage de Windows 7 n’avait pas le temps de voir les quatre orbes de couleurs se rejoindre, si ça vous parle un peu plus…

Et la fiabilité ?

Les détracteurs argueront que les SSD sont moins « solides » (haha) que les bons vieux HDD. Mon expérience personnelle me ferait plutôt répondre que c’est à peu près pareil en fait : vous pourrez tomber sur des modèles qui ne passeront pas les 10000 heures d’utilisation « chez les plateaux », voire carrément moins (surtout en cas de chute, de plus en plus courant avec les ordis portables), et certains SSD auront des problèmes bien avant, du côté du contrôleur par exemple, quand ce n’est pas un bug de firmware. Mémoire flash oblige, on ne parle pas trop en heures de fonctionnement, mais en nombre de cycles de lecture/écritures, car oui, une puce peut « flancher ». Si les premières générations étaient plus rudimentaires de ce côté-là, depuis plusieurs années maintenant les différents modèles « gardent » des cellules de côtés pour les envoyer sur le terrain quand l’un des autres joueurs est à bout de souffle. Sans parler que les cellules elles-même peuvent « simplement » être désactivées avant de mourir définitivement, le SSD continuant donc de fonctionner tout en étant « amputé ». The Tech Report a lancé un test au long cours pour justement « user » des SSD et voir leur comportement proche de la mort. Certains dépassent de loin leur spécifications, d’autres vieillissent bien… Hardware.fr s’est fendu d’un récapitulatif en français histoire de suivre le dossier, après 2 péta-octets d’écriture, soit 2 000 Téra-octets de données, soit 2 millions de Gigaoctets. Des quantités que très, très peu de personnes atteindront en pratique.

Le futur, c’est maintenant

En ce début 2015, l’augmentation des capacités commence à se tasser. Les améliorations se font avant tout sur les prix, avec une réelle dégringolade. Du côté des performances, le SATA3 pose problème au grand public, car il est saturé, conduisant les fabricants à se tourner vers d’autres formats et interfaces. Les entreprises ont le SAS et autres interfaces dédiées, et dans les laptops, on commence à voir arriver le format M.2, qui utilise quatre lignes PCI-Express en lieu et place d’un lien SATA3. Résultat, un plafond de débit qui passe de 500Mo/s à près du double, soit 1Go/s pour le PCI-E 1.0, mais jusqu’à 4Go/s avec le PCI-E 3.0.

Bref, nos machines vont de plus en plus souvent avoir moins de temps à attendre de quoi « manger » pour nous servir, et à un tarif de plus en plus intéressant 😛 Malgré tout, pour les mangeurs d’octets que sont certains d’entre vous/nous (gros contenus haute définition, photographes compulsifs, mélomanes adeptes de master audios), les disques durs classiques font de la résistance sur la taille proposée, avec par exemple HGST qui a annoncé un disque de 8To, et même jusqu’à 10To pour le stockage à froid (archivage).

[…] Avant de commencer le tutoriel je vous conseille d’avoir un disque dur HDD secondaire si vous n’en n’avez pas je vous conseilles de vous en munir si vous ne pouvez vraiment pas regarder bien dans chaque point que nous allons voir si vous avez besoin ou pas d’un disque dur HDD secondaire . Pour savoir pourquoi je vous conseille d’avoir un disque HDD secondaire , renseignez-vous sur ce qu’est ce un disque SSD. […]

Hello,

Même si votre article date de plusieurs années, je crois que les informations qu’il contient restent intéressantes. Il aide les curieux en informatique à en savoir davantage sur le SSD. Cependant, j’espère que vous aurez le temps d’écrire d’autres textes de ce genre pour présenter les nouveautés actuelles.

Hello, Du côté du stockage, on ne peut pas dire que ça change profondément depuis mon article. La révolution « flash » a eu lieu, de plus en plus de machines embarquent ce type de stockage qui s’avère au final au moins aussi performant (pour les appareils les moins coûteux sur eMMC), que fiables sur la durée. Et on s’évite le problème des pièces mécaniques. Les nouveautés se concentrent sur les procédés de fabrication et la connectique, ce ne sont que des évolutions pour accompagner performance et parfois consommation (qui est déjà bien plus faible). Si vous avez des idées de technos… Lire la suite »

Ah cela aurait été avec joie mais c’est un peu trop me demandé…Je vais y réfléchir il doit surement en avoir quelques unes 😉